Type :

- Actualités

- Applications de produits

- Études de monétisation

- Tutoriels IA

2025-01-16 09:18:31.AIbase.14.8k

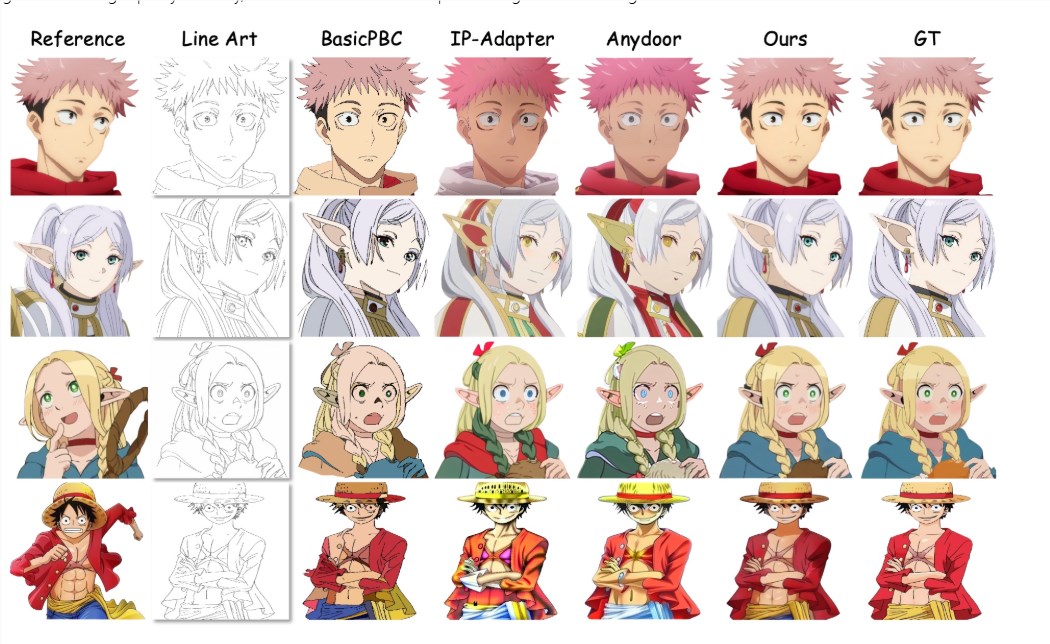

MangaNinja : Une nouvelle technique d'ombrage de dessins au trait ; Entrez un dessin au trait et une image de référence pour un ombrage précis

Récemment, une méthode d'ombrage de dessins au trait appelée MangaNinja a suscité un vif intérêt. Il suffit d'entrer un dessin au trait et une image de référence pour colorier le dessin au trait en fonction de l'image de référence. Cette technique, basée sur un modèle de diffusion, se concentre sur l'ombrage de dessins au trait guidé par une image de référence, améliorant considérablement la précision et le contrôle interactif de l'ombrage. L'équipe de recherche a mis en œuvre deux conceptions innovantes pour garantir une transmission précise des détails des personnages. Premièrement, ils ont introduit un module de réarrangement de patchs pour favoriser l'apprentissage de la correspondance entre l'image couleur de référence et le dessin au trait cible. Deuxièmement, ils ont adopté une approche pilotée par points

2024-09-24 15:08:43.AIbase.12.0k

ByteDance lance le modèle de génération vidéo Doubao : génération de vidéos de 10 secondes et cohérence multi-caméras

Lors de la tournée d'innovation IA 2024 de Volcano Engine, le président de Volcano Engine, Tan Dai, a dévoilé le nouveau modèle de génération vidéo Doubao. Ce modèle intègre plusieurs technologies de pointe, notamment une unité de calcul DIT fusionnée hautement efficace permettant un codage de compression profond de la vidéo et du texte. Il utilise également une nouvelle méthode d'entraînement de modèle de diffusion assurant la cohérence lors de la génération de vidéos multi-caméras. De plus, le modèle intègre une architecture Transformer profondément optimisée, améliorant considérablement les capacités de généralisation de la génération vidéo.

2024-08-29 14:29:37.AIbase.11.4k

Défiez la loupe ! DiPIR insère des objets virtuels de manière transparente dans des environnements réels

DiPIR est une technologie innovante visant à résoudre le problème de l'insertion transparente d'objets virtuels dans des scènes réelles. En combinant des modèles de diffusion à grande échelle et un processus de rendu inverse basé sur la physique, elle récupère avec précision les informations d'éclairage de la scène à partir d'une seule image, permettant une fusion naturelle entre l'objet virtuel et l'environnement. Le processus de DiPIR comprend la construction d'une scène 3D virtuelle, la simulation de l'interaction entre l'objet et l'environnement, et l'optimisation des conditions d'éclairage via un modèle de diffusion pour garantir que l'image générée correspond à la scène réelle. Son avantage réside dans sa grande adaptabilité, car elle convient à des scènes aux conditions d'éclairage variées et produit des images réalistes.

2024-08-15 16:59:04.AIbase.11.1k

révolutionnaire ! Lumina-mGPT peut créer des images réalistes et haute résolution à partir de texte

Les modèles de génération multimodale sont à l'avant-garde de la nouvelle vague de l'intelligence artificielle, se concentrant sur la fusion des données visuelles et textuelles pour créer des systèmes d'IA polyvalents capables d'exécuter diverses tâches, de la génération d'images à la compréhension et au raisonnement inter-types de données. L'un des défis clés est d'améliorer les capacités des modèles autorégressifs (AR) afin qu'ils puissent générer des images hautement détaillées à partir de descriptions textuelles. Bien que les modèles de diffusion excellent dans la génération d'images de haute qualité, les modèles AR accusent un retard en termes de qualité d'image, de flexibilité de résolution et de capacités de traitement multitâches. Des chercheurs du Shanghai AI Laboratory et de l'Université chinoise de Hong Kong ont présenté Lum...

2024-07-31 09:12:34.AIbase.10.7k

Stable-Hair : L'outil IA révolutionnaire pour changer de coiffure

Stable-Hair est une technologie innovante de transfert de cheveux conçue pour relever les défis posés par les technologies existantes dans le traitement de coiffures diverses et complexes, offrant ainsi aux utilisateurs une expérience d'essayage virtuel améliorée. Cette technologie utilise un modèle de diffusion pour transférer précisément une variété de coiffures réelles sur les images faciales fournies par l'utilisateur. Son processus de travail se déroule en deux phases : d'abord, un "convertisseur de tête chauve" supprime les cheveux de l'image, puis le transfert de coiffure est effectué grâce à trois modules uniques : un "extracteur de coiffure", un "réseau d'identité potentiel" et une "couche d'attention croisée des cheveux", garantissant un résultat de transfert de haute qualité.